厦大纪老师chatgpt相关讲座3.7

创始人

2024-05-30 00:33:58

0次

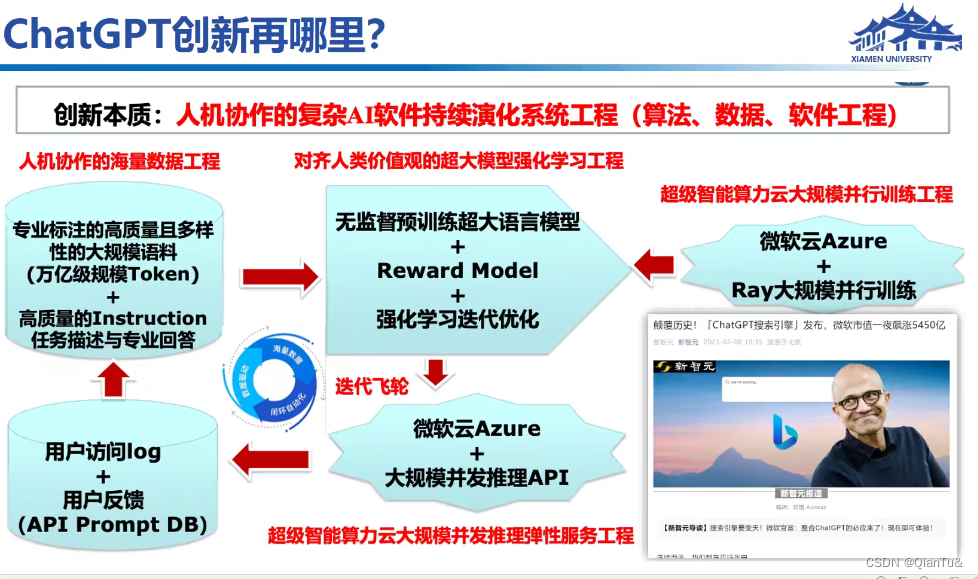

在线更新数据,迭代学习训练,进而提高模型性能。

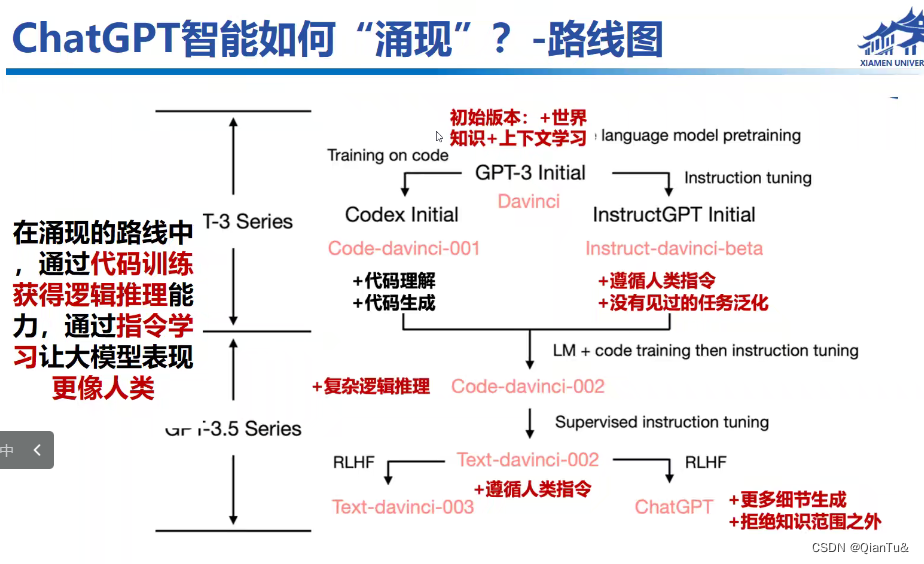

比较明显的是API部分,这一步学习的就是intruction,实现人机写作的复杂系统工程

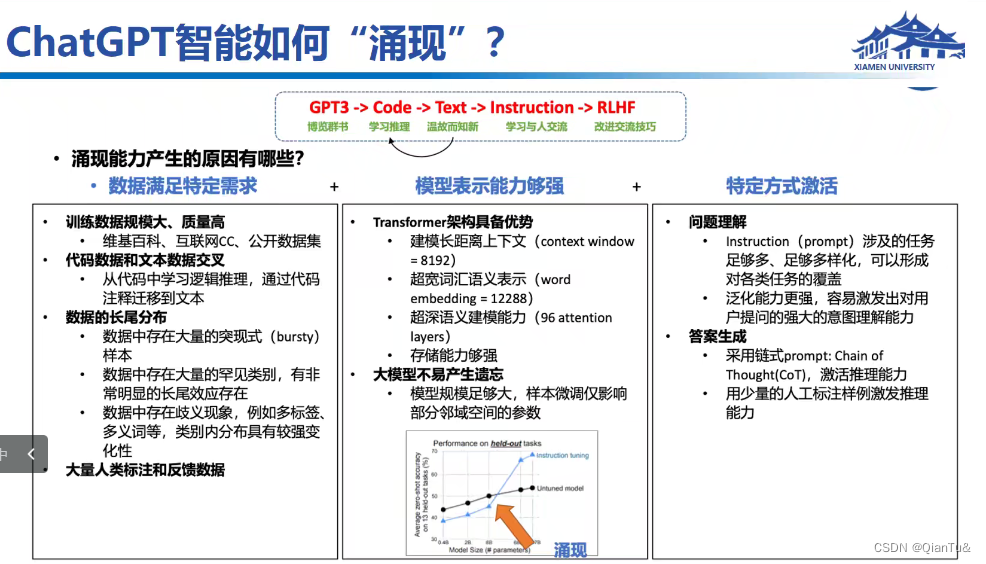

数据充足,维基类似于百度百科

transformer结构更有优势,预测下一个字,模型越大,则condition的range大。

模型遗忘是当模型做一个新任务时,就会忘记旧的任务,而模型足够大,就不会发生这种作用。

大的数据+大的模型——chatgpt

**

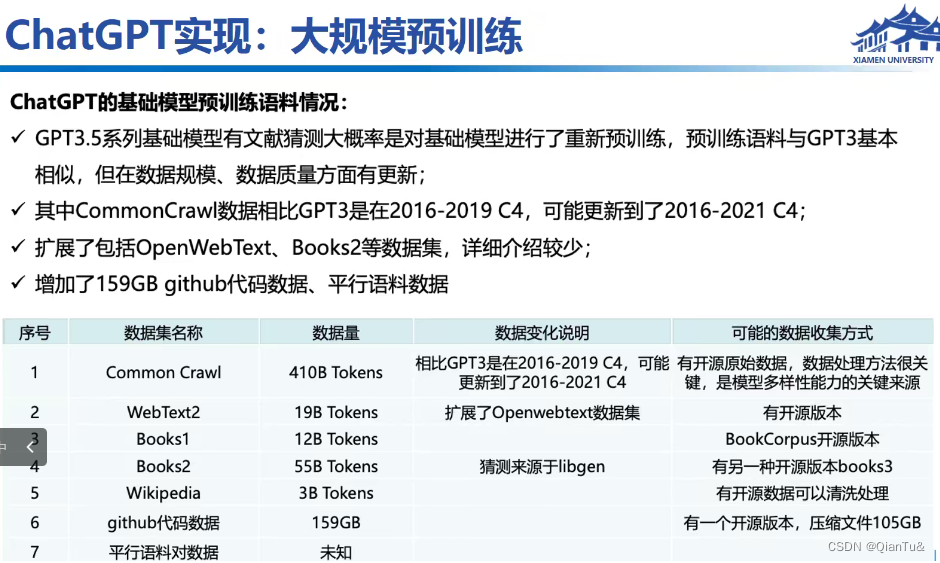

下图中的数据,多为猜测。

数据的搜集过程,无法复制?

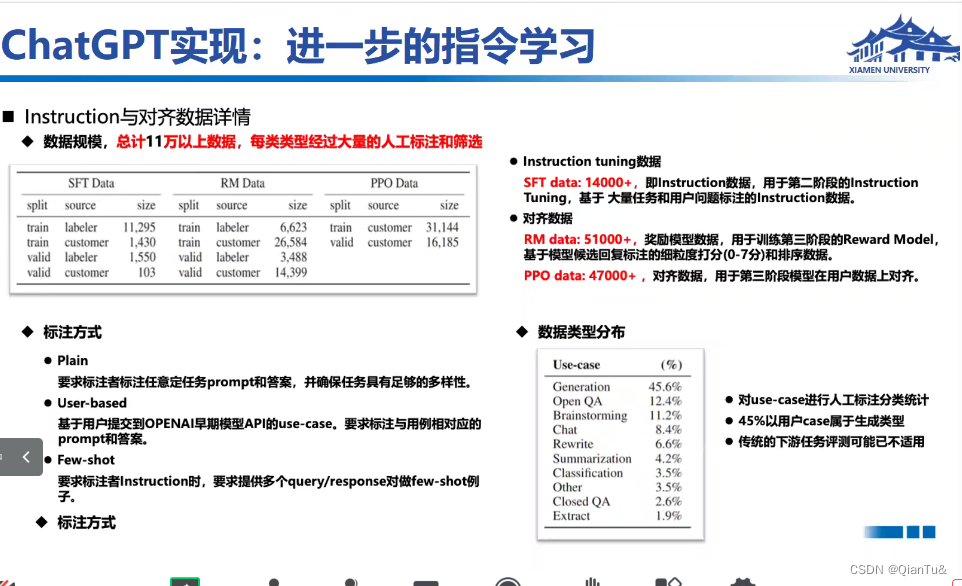

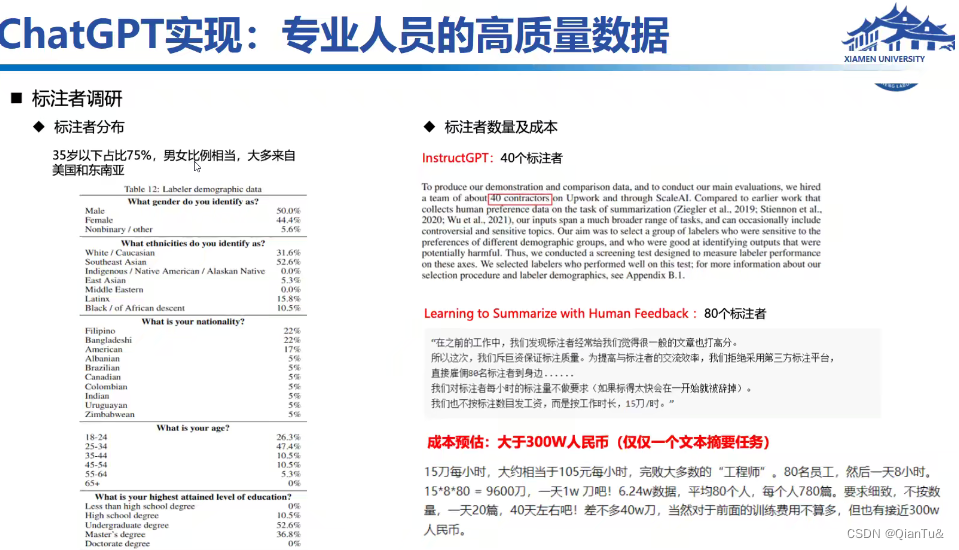

论文中给出了标注数据集类型,有QA等等,需要给出提示

不仅给出了答案,还给出推理chain。

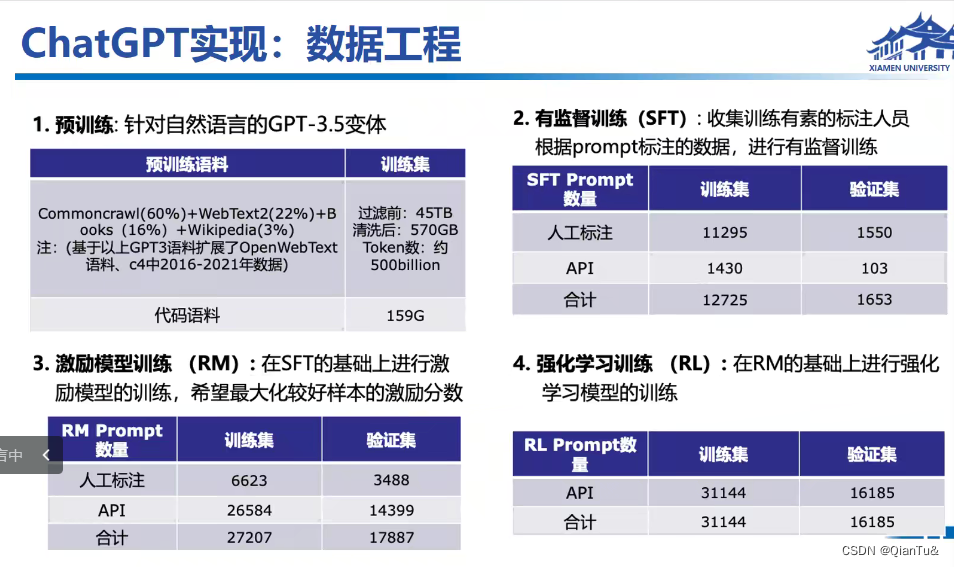

无监督预训练:文本语料570g,代码:159g

有监督:12万个训练集,1653个测试集,集合的意思,不是数据集量

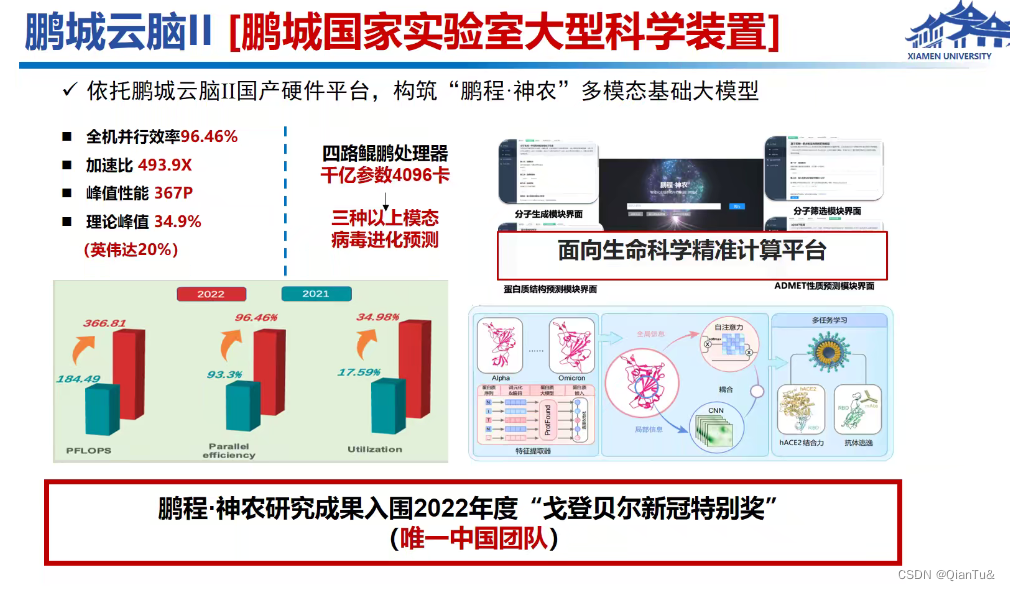

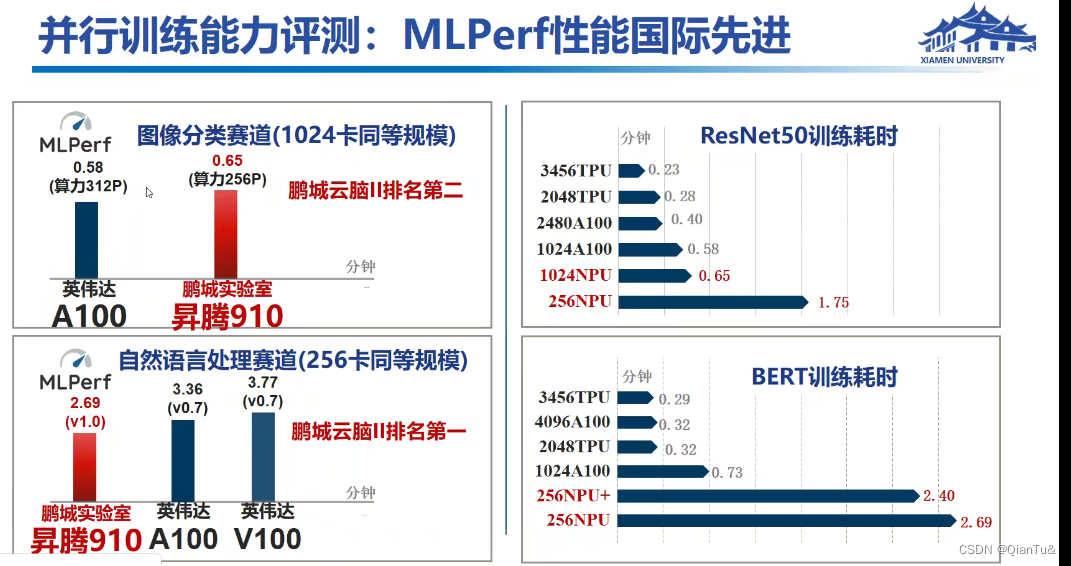

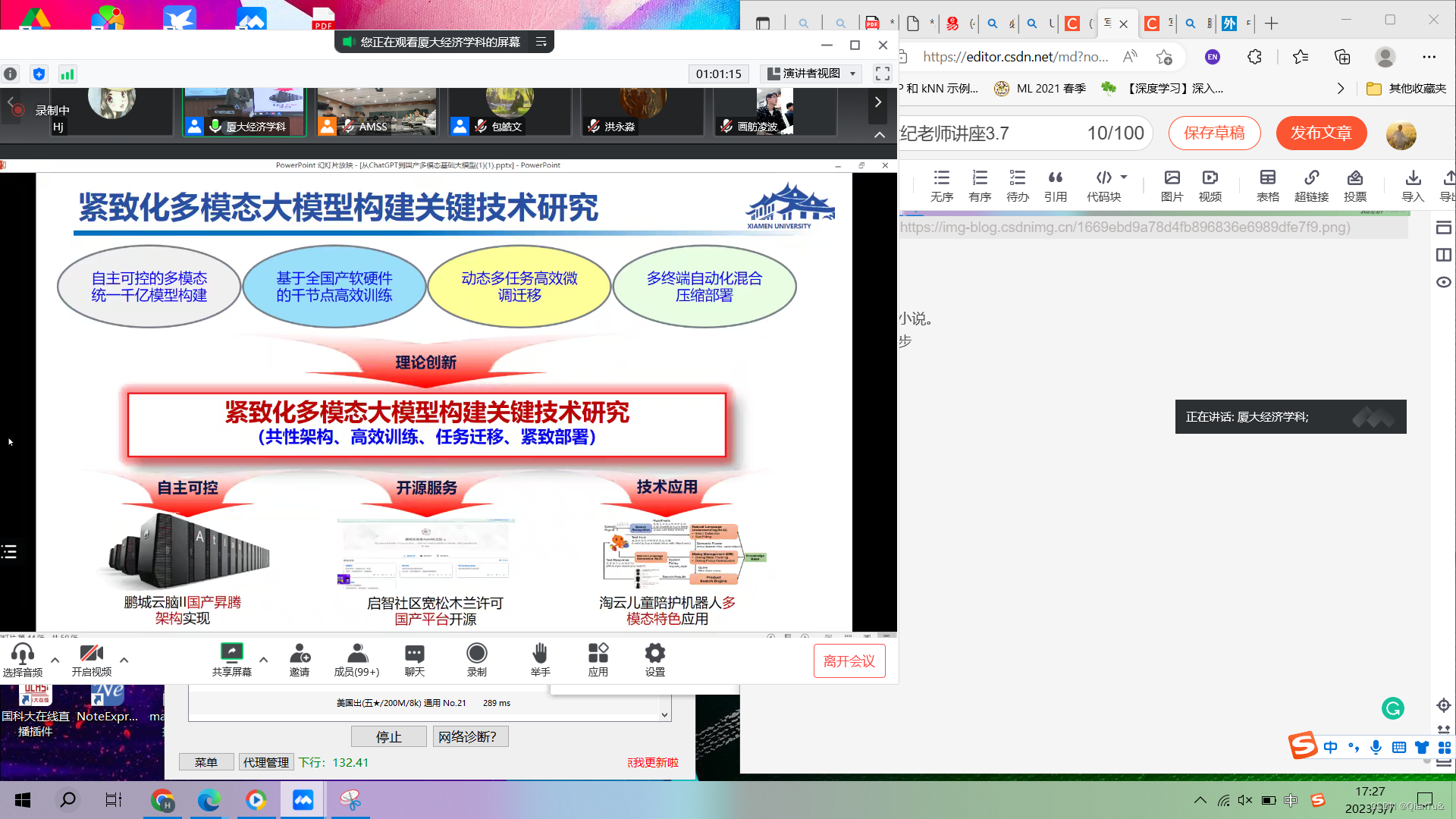

2、国产大模型硬件基础

不大指望企业,指望国家实验室

给标注数据和原始数据,他们把模型做出来。

给data,他们做模型

鹏程国家实验室不穷,很有钱

下边的模型花了27个亿

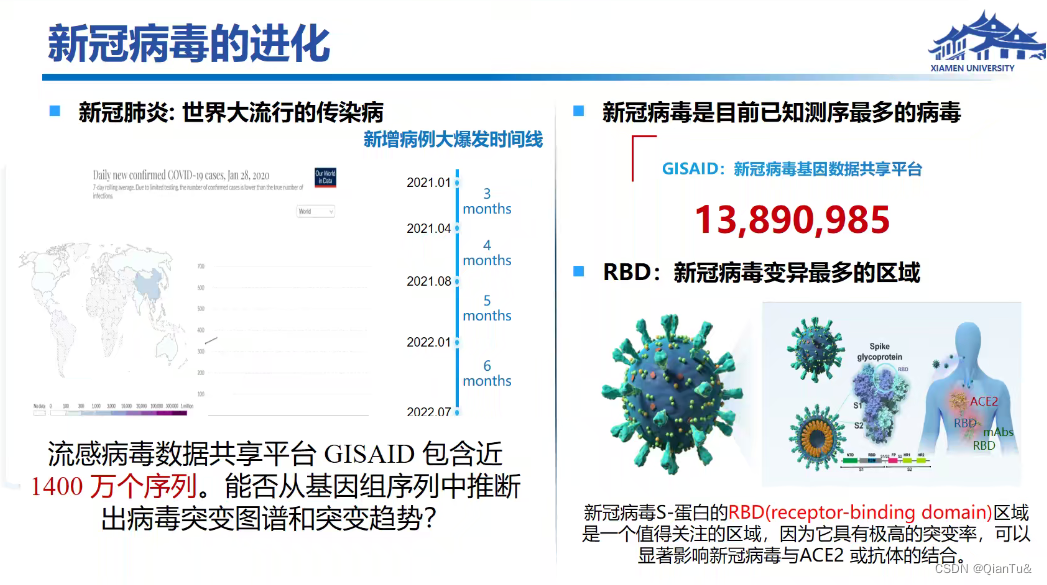

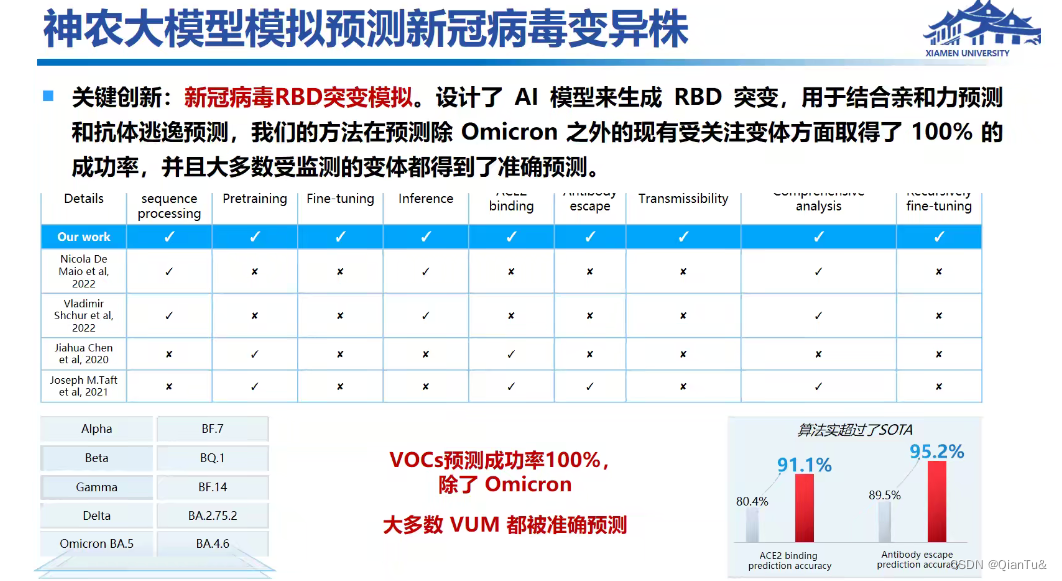

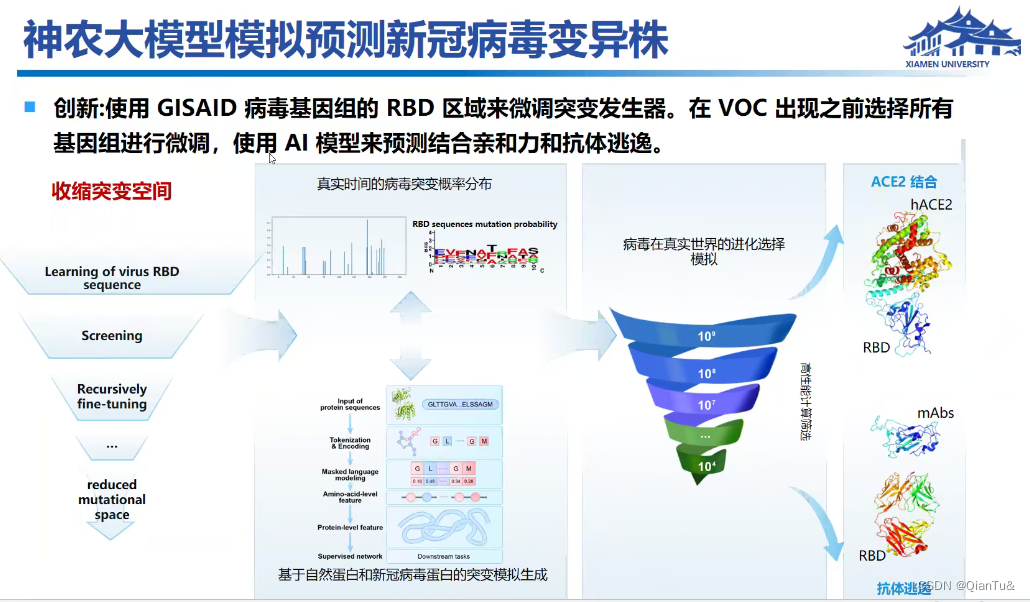

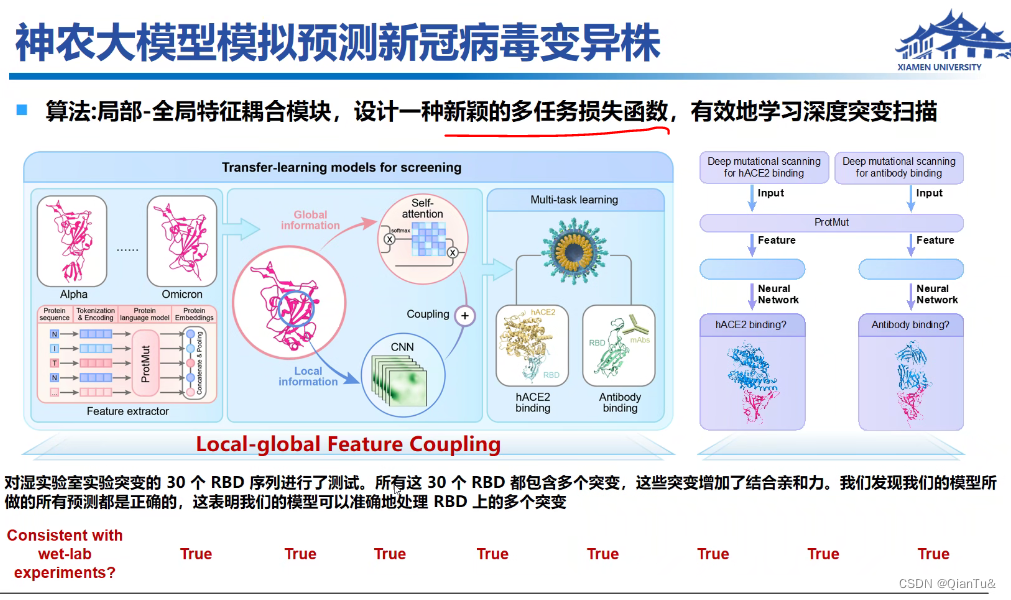

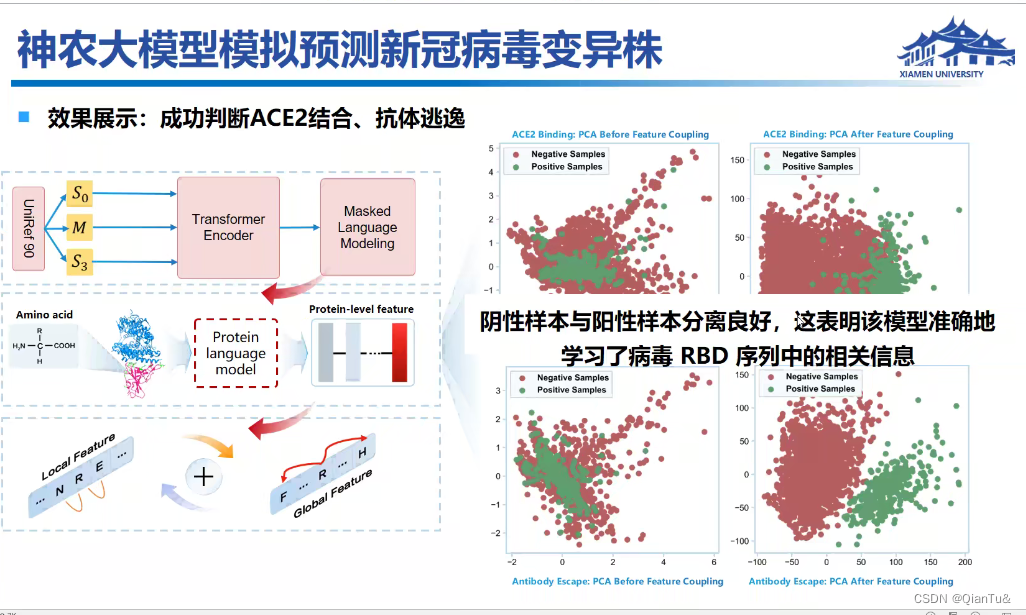

鹏程*神农——新冠预测的模型——4000张GPU卡。

国产大模型-神农模型

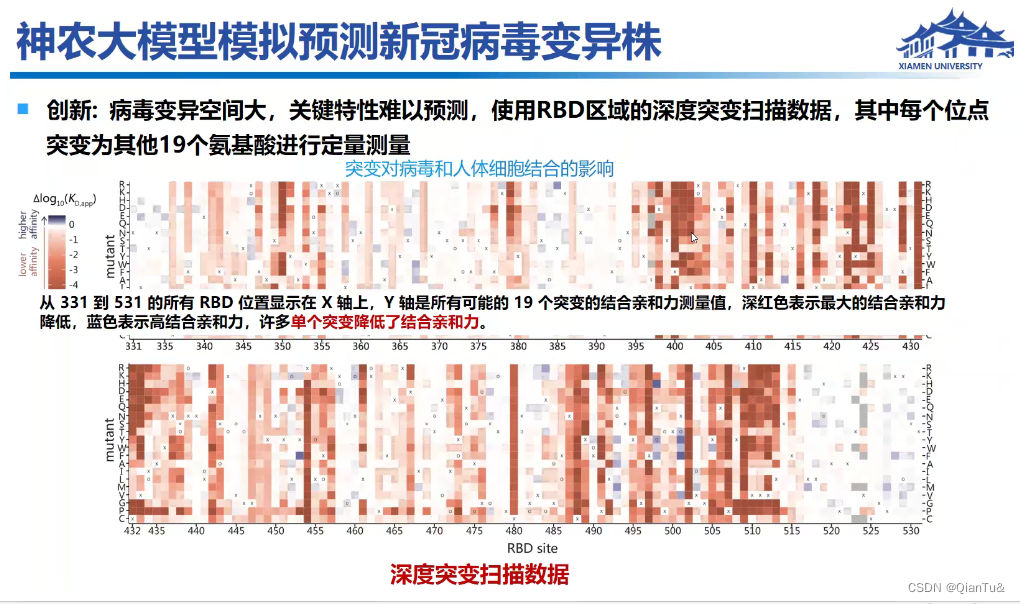

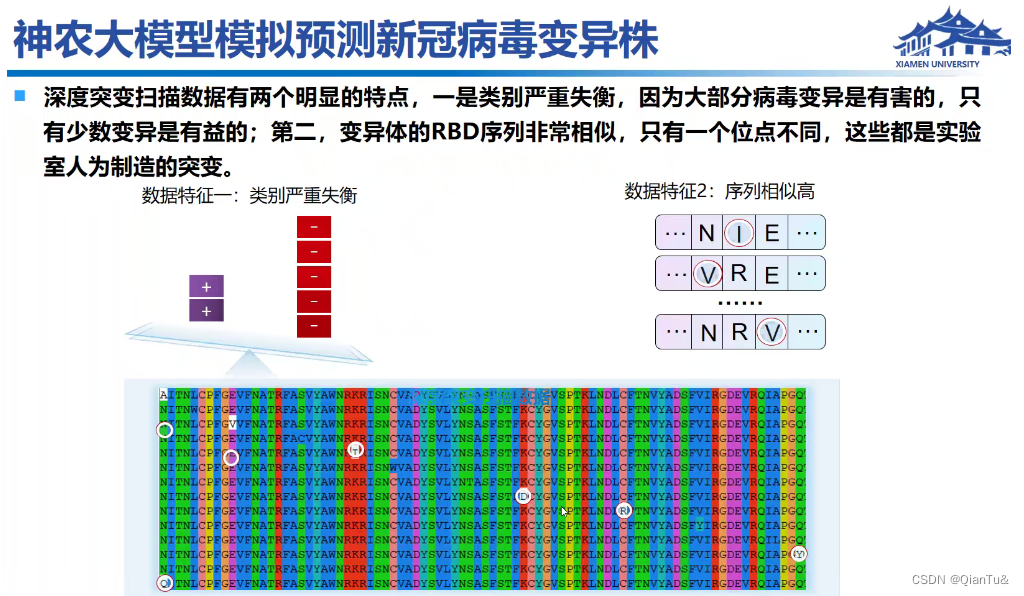

**用户需求:**蛋白的RDB区域是否病变

**研究动机:**提前预测病毒变异类型

蓝色表示结合亲力上升,月蓝色月可能发生变异

新颖的多任务损失函数,是什么?新在哪?

**

**

流感病毒能直接迁移吗?应该不行吧?流感应该不是看RBD吧?

可能的未来的方向

给一部电影,写成一本小说。

给一本小说,拍出来一步电影。

一轮300万,学生写的代码完蛋

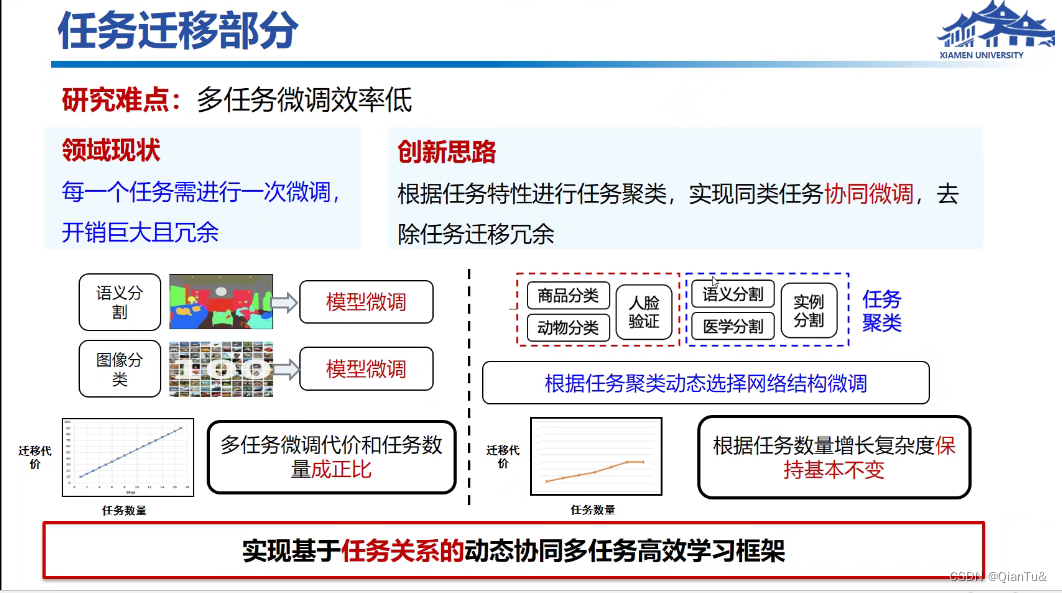

土豪做法是数据或者任务线性排,没钱,做聚类’

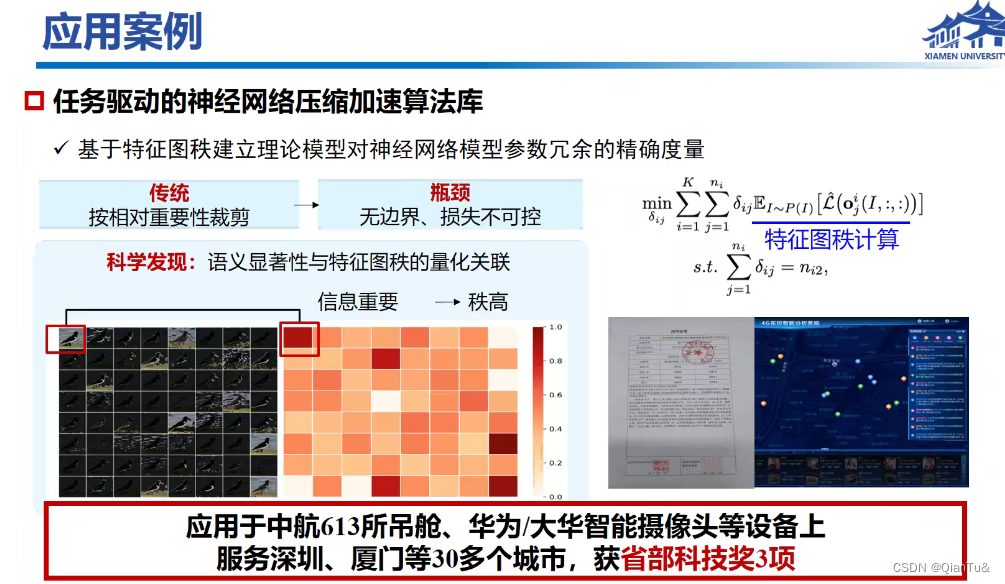

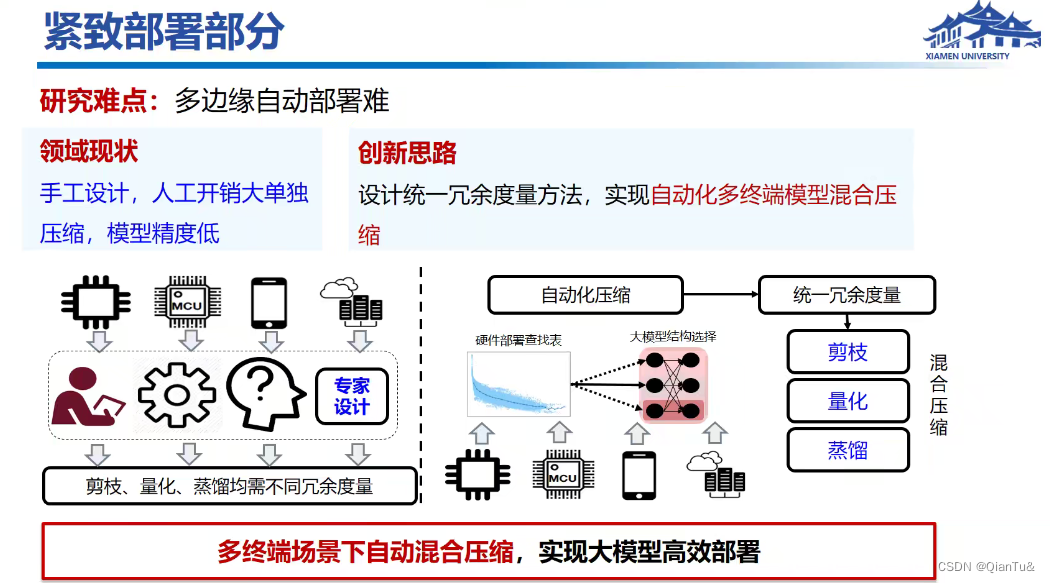

模型压缩

洪永淼:

AI领域的问题:

确定性问题(当输入和输出是确定的)

确定性答案

明确的,可控的情况下做模型。

数据量和标注数据的质量有关。

优化算法中,凸优化问题,怎么更新上万个参数?

梯度更新

相关内容

热门资讯

电视安卓系统哪个品牌好,哪家品...

你有没有想过,家里的电视是不是该升级换代了呢?现在市面上电视品牌琳琅满目,各种操作系统也是让人眼花缭...

安卓会员管理系统怎么用,提升服...

你有没有想过,手机里那些你爱不释手的APP,背后其实有个强大的会员管理系统在默默支持呢?没错,就是那...

安卓系统软件使用技巧,解锁软件...

你有没有发现,用安卓手机的时候,总有一些小技巧能让你玩得更溜?别小看了这些小细节,它们可是能让你的手...

安卓系统提示音替换

你知道吗?手机里那个时不时响起的提示音,有时候真的能让人心情大好,有时候又让人抓狂不已。今天,就让我...

安卓开机不了系统更新

手机突然开不了机,系统更新还卡在那里,这可真是让人头疼的问题啊!你是不是也遇到了这种情况?别急,今天...

安卓系统中微信视频,安卓系统下...

你有没有发现,现在用手机聊天,视频通话简直成了标配!尤其是咱们安卓系统的小伙伴们,微信视频功能更是用...

安卓系统是服务器,服务器端的智...

你知道吗?在科技的世界里,安卓系统可是个超级明星呢!它不仅仅是个手机操作系统,竟然还能成为服务器的得...

pc电脑安卓系统下载软件,轻松...

你有没有想过,你的PC电脑上安装了安卓系统,是不是瞬间觉得世界都大不一样了呢?没错,就是那种“一机在...

电影院购票系统安卓,便捷观影新...

你有没有想过,在繁忙的生活中,一部好电影就像是一剂强心针,能瞬间让你放松心情?而我今天要和你分享的,...

安卓系统可以写程序?

你有没有想过,安卓系统竟然也能写程序呢?没错,你没听错!这个我们日常使用的智能手机操作系统,竟然有着...

安卓系统架构书籍推荐,权威书籍...

你有没有想过,想要深入了解安卓系统架构,却不知道从何下手?别急,今天我就要给你推荐几本超级实用的书籍...

安卓系统看到的炸弹,技术解析与...

安卓系统看到的炸弹——揭秘手机中的隐形威胁在数字化时代,智能手机已经成为我们生活中不可或缺的一部分。...

鸿蒙系统有安卓文件,畅享多平台...

你知道吗?最近在科技圈里,有个大新闻可是闹得沸沸扬扬的,那就是鸿蒙系统竟然有了安卓文件!是不是觉得有...

宝马安卓车机系统切换,驾驭未来...

你有没有发现,现在的汽车越来越智能了?尤其是那些豪华品牌,比如宝马,它们的内饰里那个大屏幕,简直就像...

p30退回安卓系统

你有没有听说最近P30的用户们都在忙活一件大事?没错,就是他们的手机要退回安卓系统啦!这可不是一个简...

oppoa57安卓原生系统,原...

你有没有发现,最近OPPO A57这款手机在安卓原生系统上的表现真是让人眼前一亮呢?今天,就让我带你...

安卓系统输入法联想,安卓系统输...

你有没有发现,手机上的输入法真的是个神奇的小助手呢?尤其是安卓系统的输入法,简直就是智能生活的点睛之...

怎么进入安卓刷机系统,安卓刷机...

亲爱的手机控们,你是否曾对安卓手机的刷机系统充满好奇?想要解锁手机潜能,体验全新的系统魅力?别急,今...

安卓系统程序有病毒

你知道吗?在这个数字化时代,手机已经成了我们生活中不可或缺的好伙伴。但是,你知道吗?即使是安卓系统,...

奥迪中控安卓系统下载,畅享智能...

你有没有发现,现在汽车的中控系统越来越智能了?尤其是奥迪这种豪华品牌,他们的中控系统简直就是科技与艺...