YOLOv6-3.0-目标检测论文解读

文章目录

- 摘要

- 算法

- 2.1网络设计

- 2.2Anchor辅助训练

- 2.3自蒸馏

- 实验

- 消融实验

- 结论

论文: 《YOLOv6 v3.0: A Full-Scale Reloading 》

github: https://github.com/meituan/YOLOv6

上版本参考 YOLOv6

摘要

YOLOv6 v3.0中YOLOv6-N达到37.5AP,1187FPS;

YOLOv6-S达到45AP,484FPS;

扩展backbone及neck,YOLOv6-M/L达到50/52.8AP,耗时基本不变;

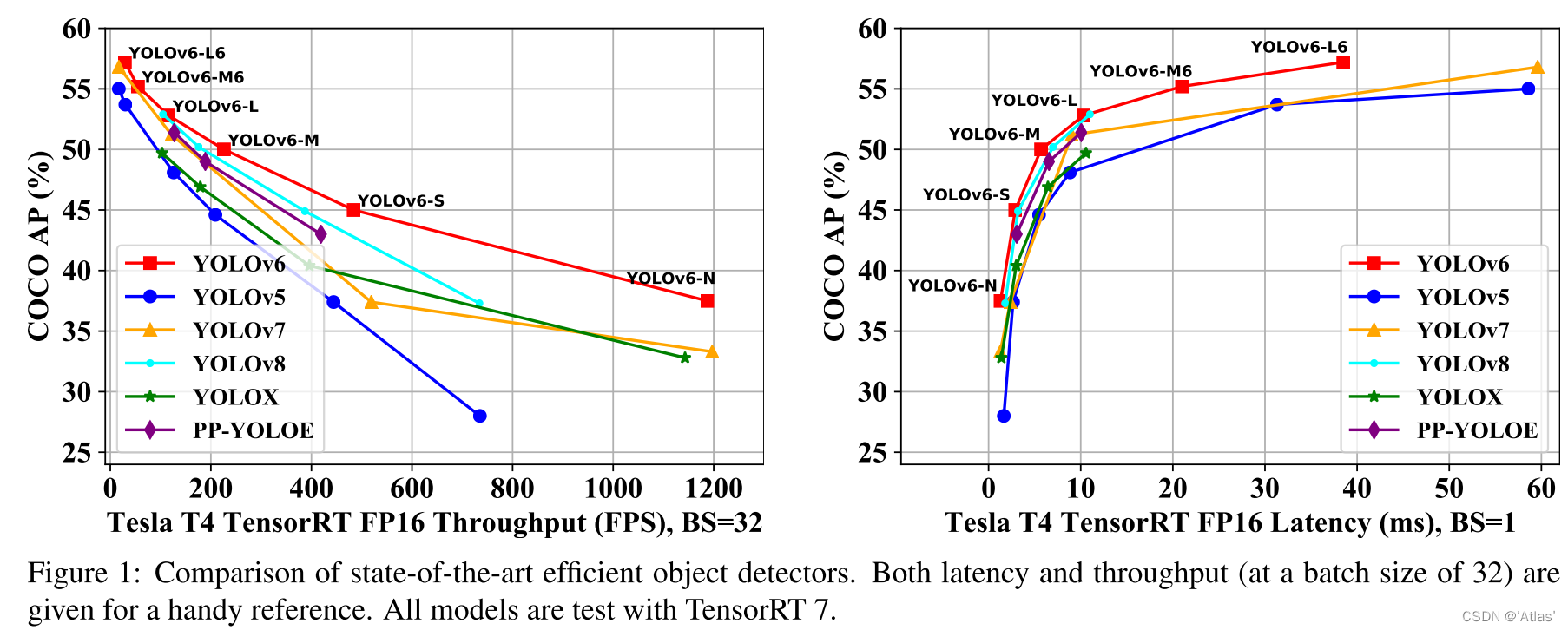

YOLOv6-L6在实时目标检测达到SOTA;图1中YOLOv6与其他版本进行比较。

YOLOv6贡献总结如下:

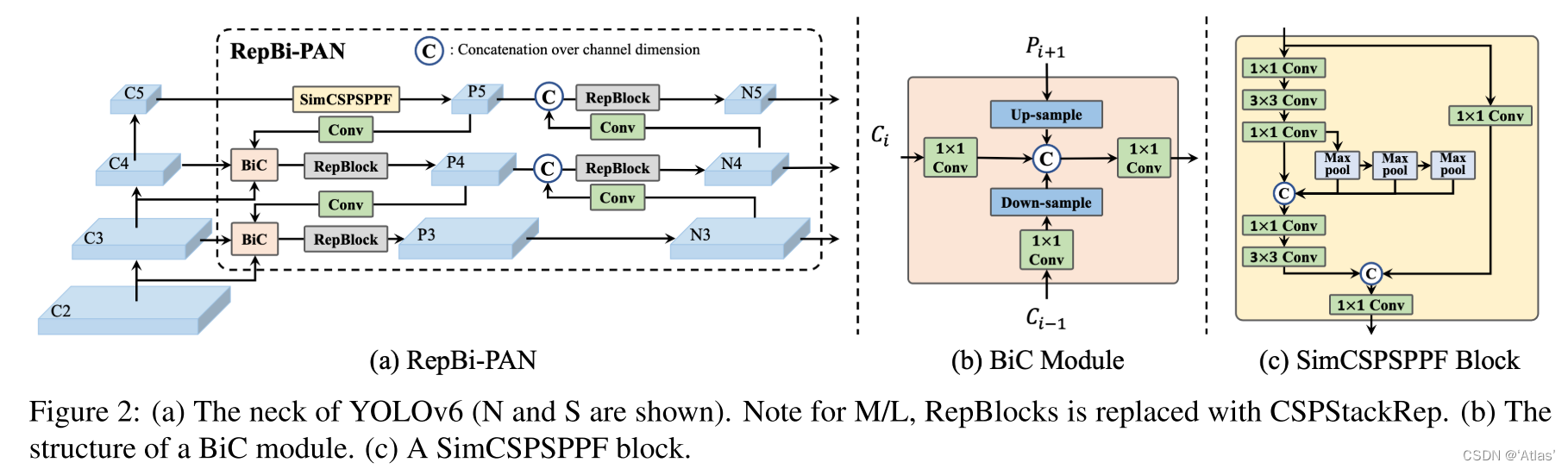

1、更新neck为RepBi-PAN,引入SiC模块及SimCSPSPPF Block;

2、使用对耗时无影响的AAT(Anchor-Aided Training)策略;

3、YOLOv6在backbone和neck中增加一个stage,强化在高分辨率输入下的表现;

4、引入一种自监督策略提升YOLOv6小模型性能,训练时使用高参数量DFL分支辅助训练回归分支,推理时去除,避免耗时增加。

算法

2.1网络设计

作者基于PAN,提出Bi-directional Concatenation(BiC)模块,如图2,融合backbone Ci-1层及Pi层特征,更多精确位置信号被保留,有利于小目标定位。

作者简化SPPF block为SimCSPSPPF Block,增强表达能力。YOLOv6中neck定义为RepBi-PAN。

2.2Anchor辅助训练

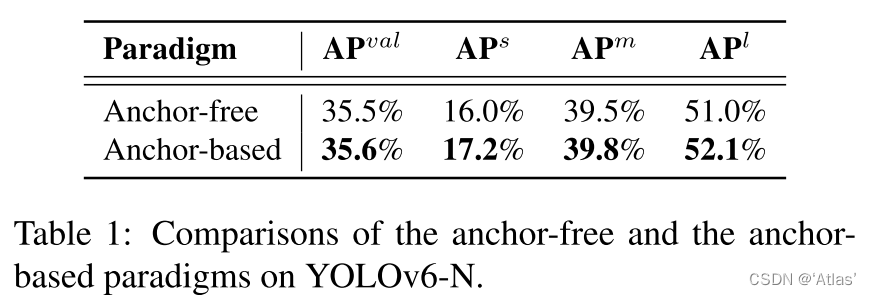

作者发现基于anchor的YOLOv6-N优于anchor-free方案,如表1

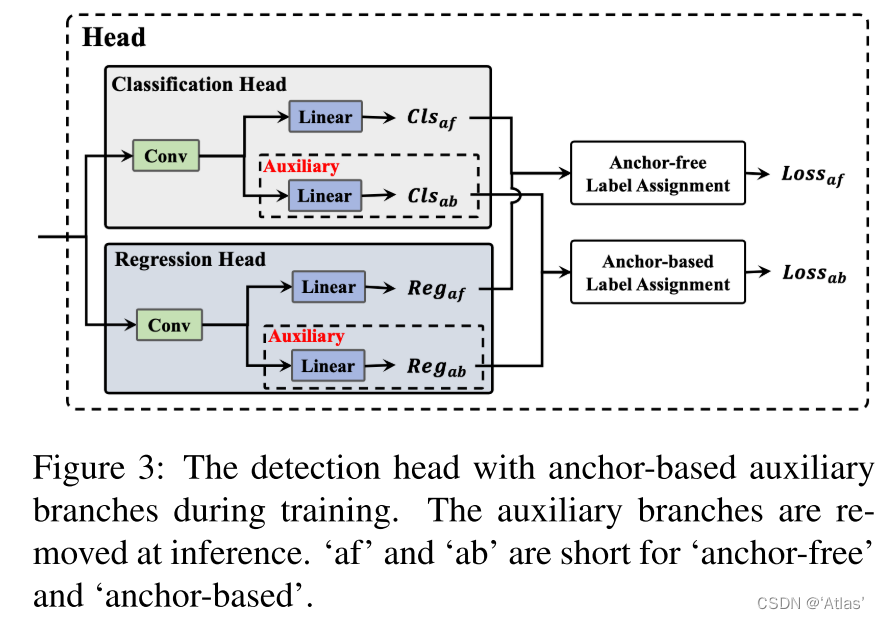

作者提出anchor辅助训练方案 (AAT)结合anchor-based及anchor-free优势,如图3,训练时辅助分支与anchor-free分支独立计算损失,辅助分支可帮助优化anchor-free head,推理时除去辅助分支,提升性能,速度不变。

2.3自蒸馏

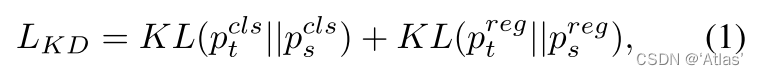

上个版本YOLOv6中自监督损失函数如式1,使用DFL进行蒸馏框回归分支。

蒸馏早期教师模型使用软标签,随着训练进行硬标签更合适,因此作者对蒸馏权重使用余弦weight decay,如式3,

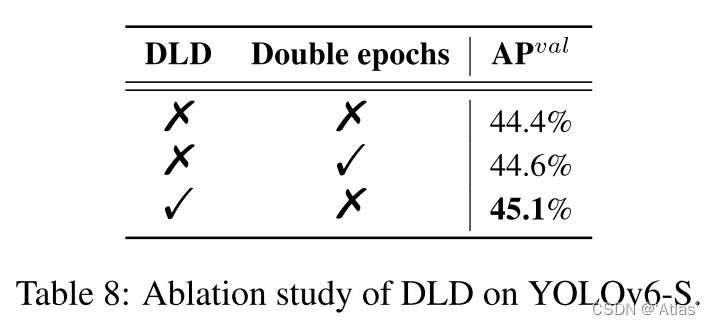

DFL将影响模型推理速度,对此作者设计Decoupled Localization Distillation(DLD),蒸馏时,学生装备原始回归分支和与DFL结合的辅助分支,教师仅使用辅助分支,原始回归分支使用硬标签训练,辅助分支使用硬标签及教师模型更新;蒸馏后,移除辅助分支。

实验

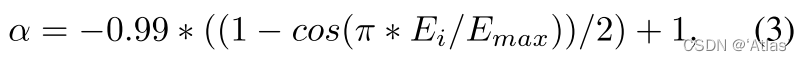

作者使用FP16精度进行各个方案比较,结果如表2,图1所示,

YOLOv6-N超越YOLOv5-N/YOLOv7-Tiny 9.5%/4.2%;

YOLOv6-S超越YOLOX-S/PPYOLOE-S 3.5%/0.9%,且耗时更短;

YOLOv6- M超越YOLOv5-M 4.6;

YOLOv6-L超越YOLOX-L/PPYOLOE-L 3.1%/1.4%;

与YOLOv8系列相比,性能接近。

作者类似YOLOv5在backbone 增加C6层用于检测更大目标,neck相应做出调整, 分别命名为YOLOv6- N6/S6/M6/L6;实验结果如表2,

与YOLOv5相比,性能提升,推理速度基本不变;

与YOLOv7-E6E相比,YOLOv6-L6性能提升0.4,耗时缩短63%;

消融实验

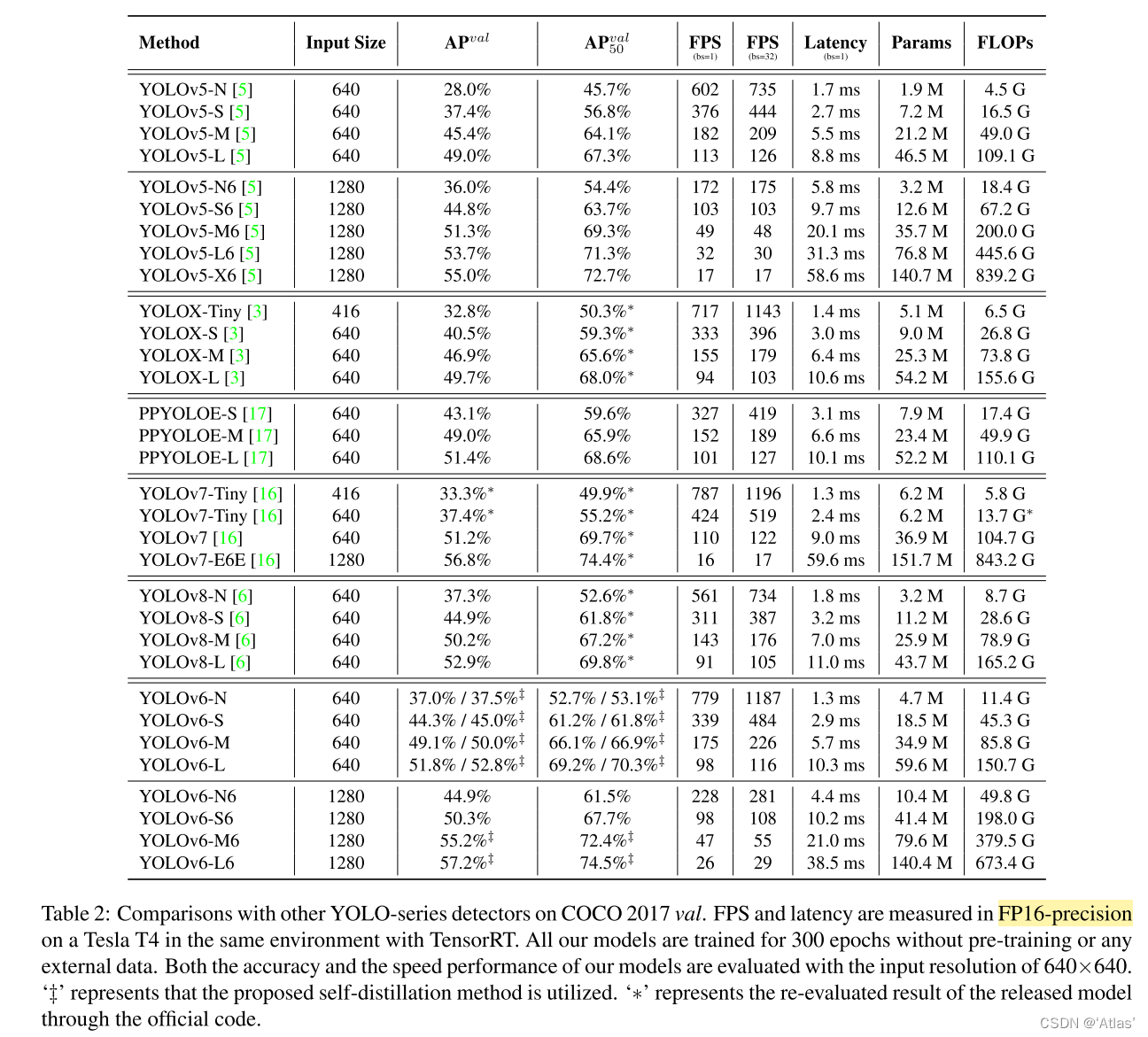

消融实验如表3,BiC+SimCSPSPPF使得性能提升0.6%;AAT使得性能提升0.3%;DLD使得性能提升0.7%;

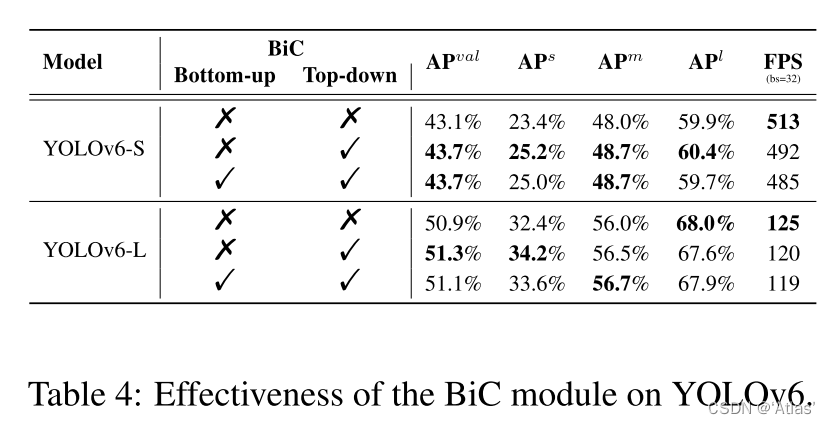

BiC模块影响实验如表4,在PAN top-down路径插入BiC,YOLOv6-S/L性能提升0.6%/0.4%;但插入bottom-up路径为带来增益,作者分析由于bottom-up路径中BiC将导致检测头易混淆不同尺度特征;

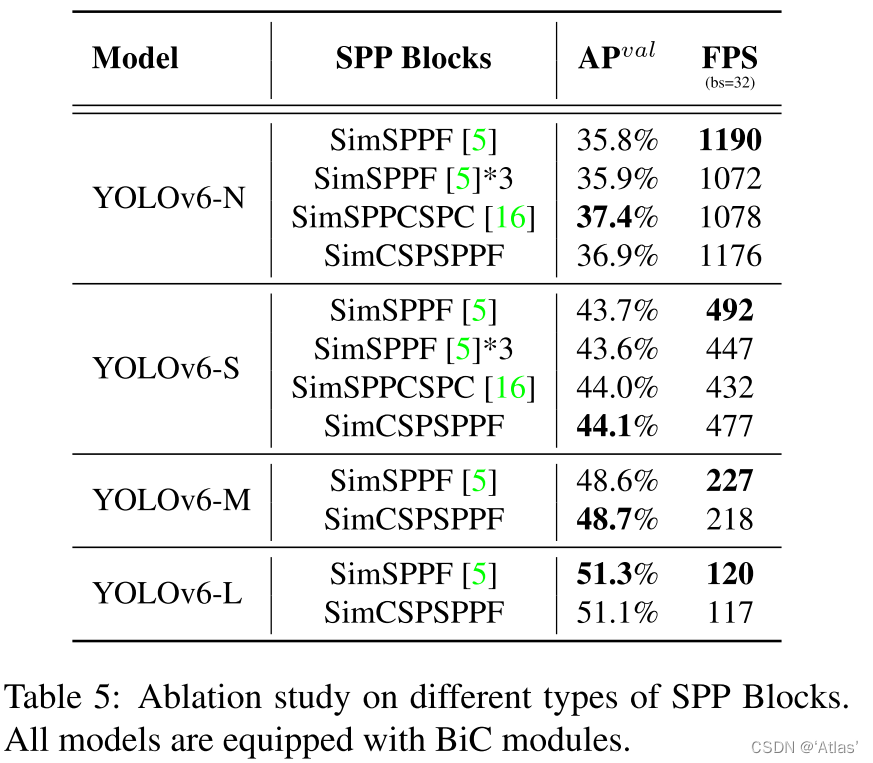

表5表示不同类型SPP block影响,SimSPPF*3表示P3, P4 and P5层使用SimSPPF blocks,SimSPPCSPC在 YOLOv6-N/S上超越SimSPPF 1.6%/0.3%,但耗时增加;

在YOLOv6- N/S/M上,SimCSPSPPF超越SimSPPF 1.1%/0.4%/0.1%;

考虑到性能与耗时均衡,作者在YOLOv6-N/S使用SimCSPSPPF,YOLOv6-M/L使用SimSPPF blocks;

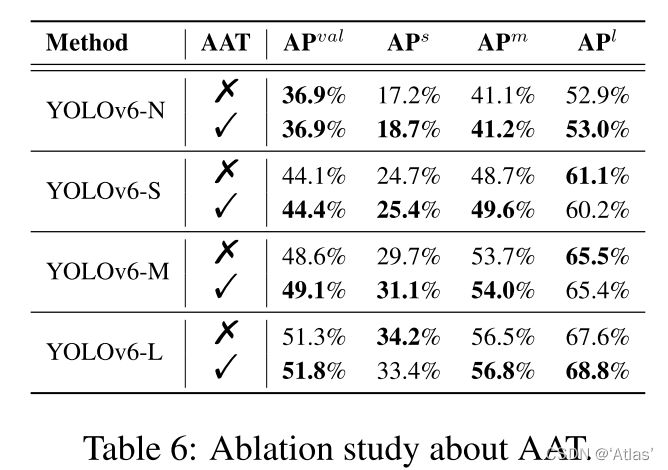

如表6,anchor辅助训练(AAT)在YOLOv6-S/M/L上,带来0.3%/0.5%/0.5%性能提升;在YOLOv6-N/S/M上小目标性能显著提升;

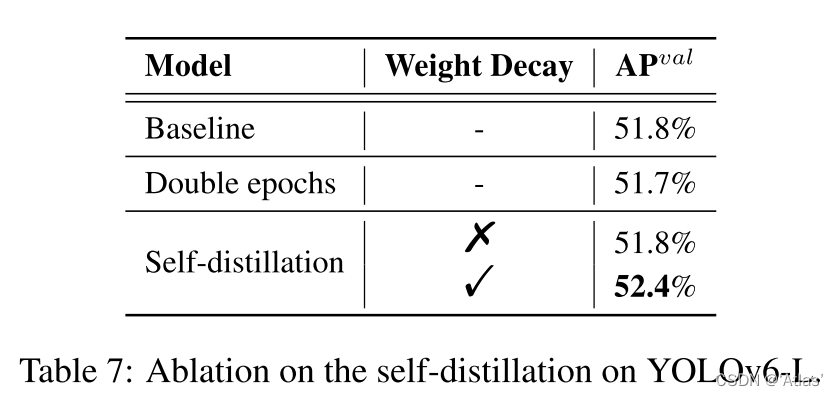

表7表明在YOLOv6-L上weight decay使得性能提升0.6%;

表8表明在YOLOv6-S上DLD带来0.7%性能提升;

结论

作者将YOLOv6进一步提升,在实时目标检测领域达到SOTA。